Комплексный аудит сайта на основе ключевых требований поисковых систем позволяет улучшить видимость сайта в результатах поиска, найти точки роста и получать больше органического трафика.

Какова цель SEO аудита?

Целью мероприятий по SEO аудиту сайта является исправление технических недочетов, которые могли привести к санкциям со стороны поисковых систем и снижению видимости страниц в поисковой выдаче.

5 главных проблем, которые решает SEO аудит

Вне зависимости на каком отрезке жизненного цикла находится проект, его владелец может столкнуться с этими проблемами:

- На сайт был наложен фильтр,

- На сайте мало органического трафика из поиска,

- Сайт плохо индексируются в поисковых системах,

- В кабинете веб-мастера найдены ошибки,

- У сайта низкие позиции в результатах поиска.

В этом материале мы рассказываем, как провести базовый SEO аудит сайта самостоятельно и что для этого требуется.

Статья оформлена в формате чек-листа на тематические блоки, каждый из которых содержит информацию о конкретном направлении оптимизации.

Сервисы для самостоятельного SEO аудита

Это список сервисов, которые мы используем на практике, и закрываем большинство наших потребностей, возникающих в процессе аудита:

- Google Search Console,

- Яндекс.Вебмастер,

- Яндекс.Метрика,

- Semrush,

- Lighthouse.

Перед выполнением SEO аудита подключите ваш сайт к сервисам из списка и дождитесь сбора данных, вскоре они пригодятся для поиска ошибок.

Аудит веб-сервера

Аудит конфигурации сервера требуется для решения технических проблем связанных со сканированием страниц поисковым роботом.

Коды ответов

Убедитесь, что коды ответов сервера совпадают со статусами страниц на сайте. Страницы, которые доступны для просмотра должны отвечать кодом — 200 ОК, удаленные — 404 Not Found, с перенаправлением — 301 Moved Permanently, системные каталоги — 403 Forbidden.

Для проверки кодов ответа, используйте утилиту cURL. Чтобы узнать код состояния у конкретного URL, выполните запрос:

curl -Is -o /dev/null -w "%{http_code}\n" https://example.comЕсли коды ответов отличаются от состояний публикаций на сайте, повторите настройку конфигурации веб-сервера.

Заголовки ответов

HTTP-заголовки могут содержать специальные директивы, которые успешно сканируются поисковыми роботами наравне с кодами ответов.

Иногда виновником неудачного сканирования документов на стороне сервера является заголовок X-Robots-Tag. Он может содержать запрещающие директивы: noindex, none и препятствовать сканированию страниц поисковыми ботами.

Редирект с www

Если сайт предполагает использование без приставки www, убедитесь, что на сервере настроен редирект с www на без www. Поисковые системы рассматривают доступность ресурса по двум адресам как зеркала, что отрицательно сказывается на качестве его индексации.

Редирект на протокол HTTPS

При использовании безопасного соединения на основе SSL, проверьте настройку перенаправлений адресов с протокола HTTP на HTTPS. Все страницы сайта должны быть доступны только через HTTPS.

Скорость ответа

Длительный отклик сервера (> 200 мс), негативно влияет на удобство взаимодействия с сайтом и индексацию контента поисковыми роботами. Чтобы узнать скорость отклика ответа сервера у конкретного URL, выполните запрос:

curl -s -o /dev/null -w "%{time_total}\n" https://example.comОптимизация этого показателя улучшает опыт пользователей и предотвращает ошибки при массовом переобходе страниц.

Анализ страниц

Качество страницы является главным фактором ее успешного индексирования. В процессе аудита важно определить, какие страницы являются ценными и по каким причинам они могли быть проигнорированы поисковыми ботами.

Дубли страниц

Дублирование страниц — распространенная ошибка на сайте, которая встречается на протяжении всего периода его работы. Если на сайте доступен одинаковый контент по разным URL-адресам, один из таких адресов признается дублем.

Дубли могут возникать не только из-за взаимодействия пользователя с интерактивными элементами, такими как фильтры или пагинация, но и в результате неверной работы веб-сервера.

Выгрузить список известных дублей можно из консоли веб-мастера в формате таблицы. Определите основные причины их возникновения и внесите изменения на сайте.

Прямые дубли

В случае обнаружения прямых дубликатов, задайте канонические адреса для альтернативных версий страниц, чтобы в индекс попали не все документы, а только канонические.

Дубли с параметрами

Для запрета обхода адресов с GET-параметрами, запишите их в файл Robots.txt с помощью директивы Clean-param для Яндекса, например:

User-agent: Yandex

...

Clean-param: utmДля остальных поисковых систем задайте значение для директивы Disallow, например:

User-agent: *

...

Disallow: /*?*Наполнение страницы

Текст на страницах должен быть уникальным, релевантным, содержать ключевые слова и иметь четкую структуру. Это касается заголовков H1-H2, картинок, списков, таблиц и видео.

Страницы с низким качеством текста

Страницы на которых нет или недостаточно текста для ранжирования в поиске, справедливо признаются поисковыми системами как некачественные или малополезные. Текст с грамматическими ошибками и недочетами, мешающими восприятию пользователя, с высокой долей вероятности не попадет в индекс.

Перелинковка

Высокая согласованность текстов не только улучшает пользовательский опыт, но и помогает поисковым роботам понимать структуру сайта, чтобы находить на нем ценные материалы.

Проверка внутренних ссылок предполагает анализ анкоров, протоколов URL, перенаправлений. Полезная ссылка должна вести на релевантный адрес согласно ее анкору и не иметь перенаправлений.

Примеры плохих внутренних ссылок

| Ссылка | Код | Назначение | В чем ошибка? |

|---|---|---|---|

| https://example.com/catalog | 301 | https://example.com/catalog/ | В конце ссылки не указан / |

| https://www.example.com/catalog/ | 301 | https://example.com/catalog/ | Содержит приставку www, при переходе сработал редирект на версию сайта без www |

| http://example.com/catalog/ | 301 | https://example.com/catalog/ | Указан небезопасный протокол HTTP |

| https://example.com/?p=1001 | 404 | https://example.com/404/ | Ведет на битый URL |

Смешанное содержимое

При использовании SSL-сертификата на сайте, важно убедиться, что все страницы отдают контент только через HTTPS. Проверить наличие проблем при загрузке файловых ресурсов можно в консоли для разработчиков (DevTools).

Удобство просмотра и навигации

Основные системы ранжирования Google отдают приоритет контенту, который размещен на удобных для просмотра страницах. В первую очередь, это показатели Core Web Vitals и поддержка защищенного соединения.

При этом удобство зависит не только от этих двух аспектов, страница в целом должна производить благоприятное впечатление на пользователей.

Показатели производительности сайта учитываются алгоритмами поисковых систем при ранжировании документов и напрямую влияют на поведение пользователей.

Убедитесь, что все URL загружаются быстро, нет серьезных проблем с ключевыми показателями (LCP, CLS, INP), а кэширование статических ресурсов настроено оптимально.

Метаинформация

Метаданные отвечают за формирование сниппетов в результатах поиска. От правильности их заполнения зависит успех первого касания с пользователями поисковых систем. Проверьте корректность заполнения метатегов. Они должны быть уникальными для каждого URL:

Элемент Title

Заголовок — это текст, определяемый в HTML элементом title, который принадлежит к секции <head>. Он отображается во вкладках, закладках браузера и поисковой выдаче в виде ссылки.

Метатег Description

Описание — это текст, определяемый в HTML метатегом description. Описание является одним из источников данных, на основе которых формируются сниппеты документов в результатах поиска.

Рекомендации по заполнению метатегов

| Элемент | Корректная длина для SEO |

|---|---|

| Title | от 50 до 70 символов |

| Description | от 120 до 160 символов |

Метатег Robots

Как и его серверный аналог X-Robots-Tag, применяется в качестве средства контроля за обработкой страницы поисковыми роботами. Он может содержать запрещающие директивы: noindex, none, которые указывают роботам, что страница недоступна для индексирования.

404 страница

Поисковые роботы применяют коды ответа для проверки состояния страниц в поисковых индексах. Ошибка 404 Not Found является причиной исключения ранее доступной страницы из поисковой выдачи.

Система управления контентом в случае возврата ошибки веб-сервером выполняет перенаправление пользователя на служебный URL. Он должен быть согласован с основным дизайном сайта, содержать сообщение об ошибке и иметь удобную навигацию.

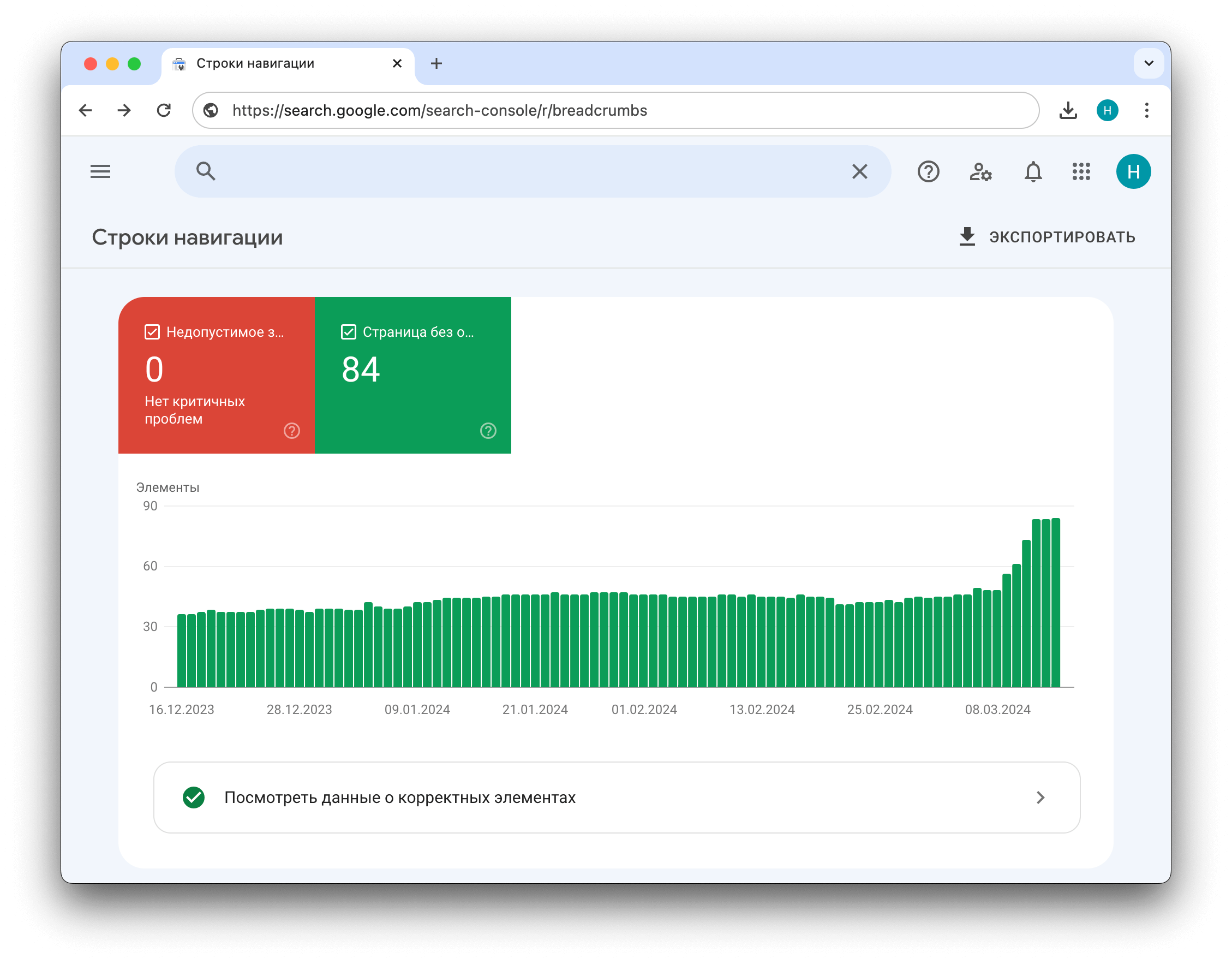

Улучшения

Структурированные данные позволяют использовать возможности расширенного представления сниппетов в результатах поиска. Их применение позитивно влияет на CTR сниппета в поисковой выдаче и улучшает поведенческие факторы.

Поисковики поддерживают множество типов микроразметки данных на основе протокола Schema.org. Внедрение разметки позволяет создать дополненное представление для контента различных форматов: статей, рецептов блюд, рецензий на книги, видеоматериалов.

Ошибки и некорректное внедрение считается нарушением правил поисковых систем и влечет за собой наложение санкций. Это может быть причиной низкого ранжирования страниц в результатах поиска.

Перед внедрением кода важно ознакомиться с правилами использования микроданных. Подробнее о них можно прочитать в справке.

Чтобы проверить корректность микроразметки, можно использовать встроенный валидатор в панели для веб-мастеров или альтернативные сервисы: от Google или Schema.org.

Человекопонятные URL

Конечные URL-адреса должны соответствовать общей концепции SEO-friendly, а именно: быть понятными и краткими, содержать ключевые слова, соблюдать иерархию каталогов.

Настройка ЧПУ выполняется в системе управления контентом и представляет из себя шаблон для создания однотипных адресов страниц.

Пример ЧПУ в каталоге товаров

| Шаблон | Тип | Конечный URL |

|---|---|---|

| /catalog/#SECTION#/ | Раздел | https://example.com/catalog/tovary-dlya-doma/ |

| /catalog/#SECTION#/#ELEMENT#/ | Карточка товара | https://example.com/catalog/tovary-dlya-doma/skovoroda-litaya/ |

| /catalog/#SECTION#/filter/#PARAM#/ | Фильтр товаров | https://example.com/catalog/tovary-dlya-doma/filter/brand-is-indesit/ |

Поисковая система

Аудит сайта на основе данных из поисковых систем направлен на выявление технических недочетов, влияющих на представление сайта в поиске. Для выполнения базового аудита достаточно выгрузить данные о сайте из поисковых консолей Яндекса и Google.

Фатальные и критичные ошибки

Встроенный инструмент диагностики сайта в поисковой консоли Яндекса — дополнительный источник данных о грубых ошибках, возникающих при сканировании сайта.

Настройте уведомления по эл. почте для контроля проблем, возникающих при взаимодействии сайта с поисковой системой. В случае обнаружения неполадок, исправьте их согласно рекомендациям.

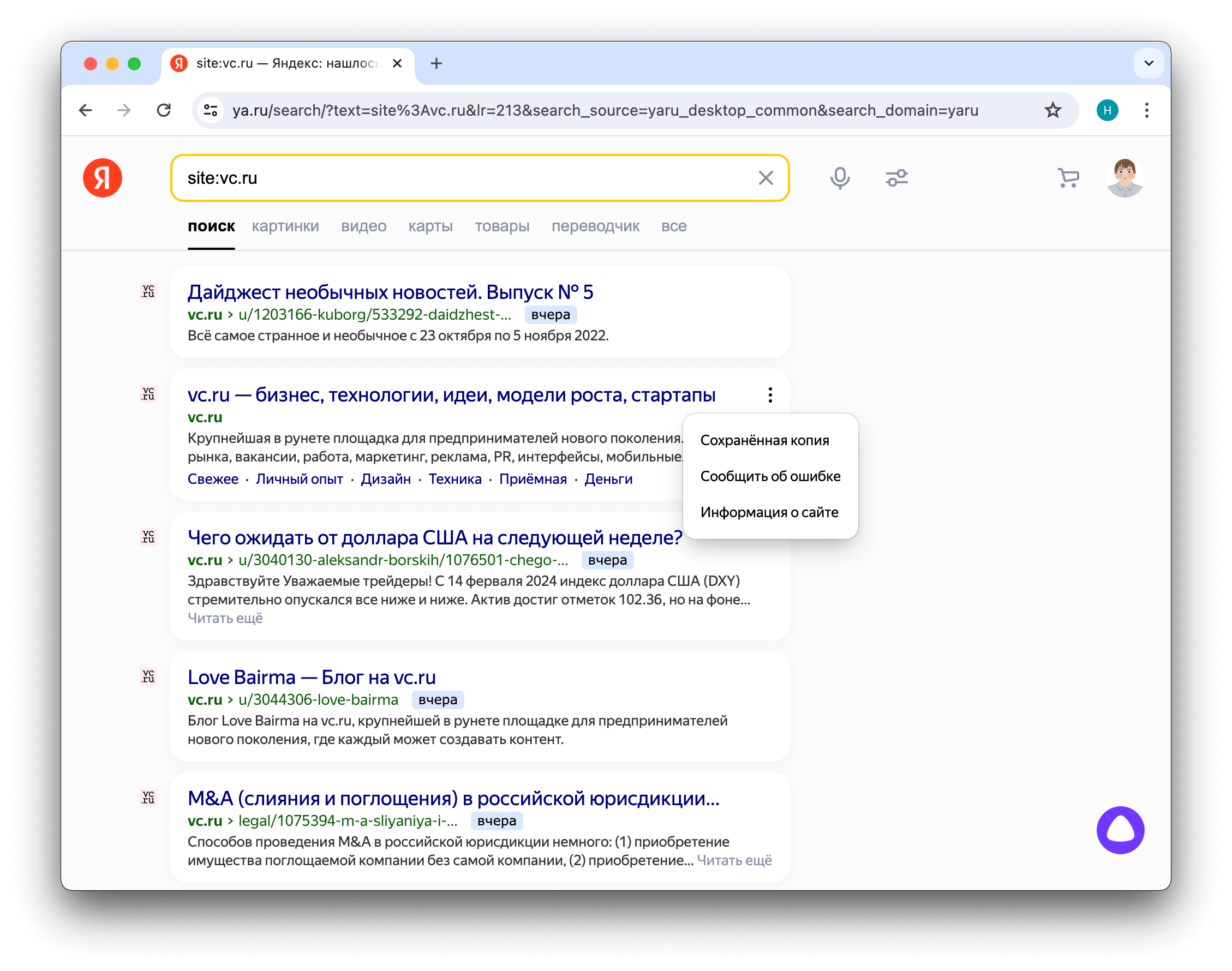

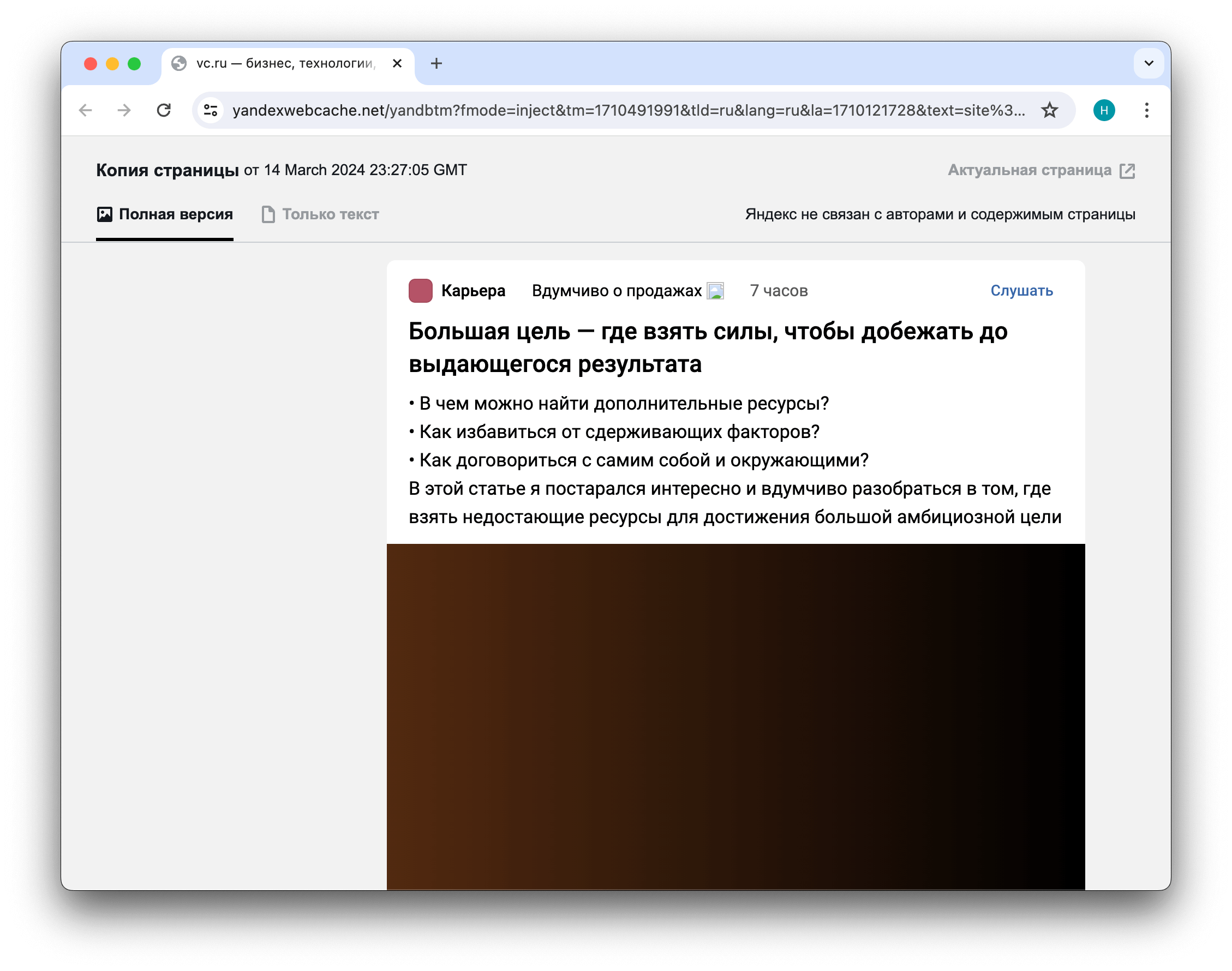

Сохраненные копии

Проверка кэшированных версий страниц помогает определить, как поисковая система извлекает информацию со страниц сайта.

Выполните запрос к поисковой системе с помощью оператора site:

site:example.comОткройте сохраненную копию документа на выдаче через меню сниппета:

Удостоверьтесь, что обе версии — как полная, так и текстовая — корректно отображаются. Дизайн страницы должен совпадать с оригиналом, а текст быть доступным.

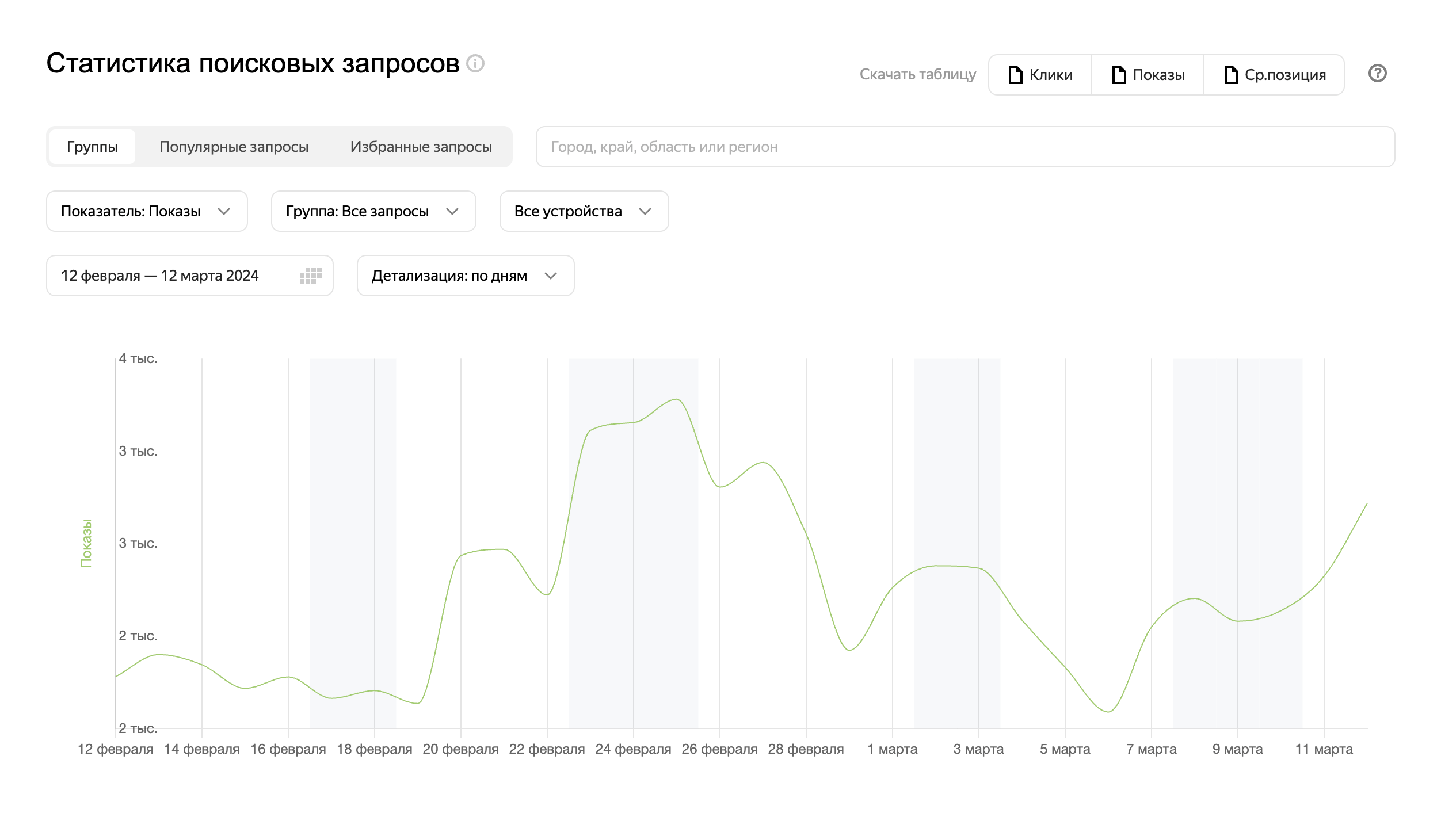

Видимость в поиске

Статистика показов сайта в поисковой выдаче может указывать на проблемы с его индексированием: резкое снижение или отсутствие показов являются признаками недостаточной семантики, наличия поисковых фильтров и неверной обработки URL из-за технических проблем.

Файл Robots.txt

Robots.txt — текстовый файл, который содержит директивы и их значения для управления поведением поисковых роботов. Этот файл обязателен для SEO и должен быть размещен в корневой директории сайта.

От его настройки зависит, какие страницы и разделы будут доступны для сканирования поисковыми системами. Частые проблемы, которые встречаются из-за некорректной настройки:

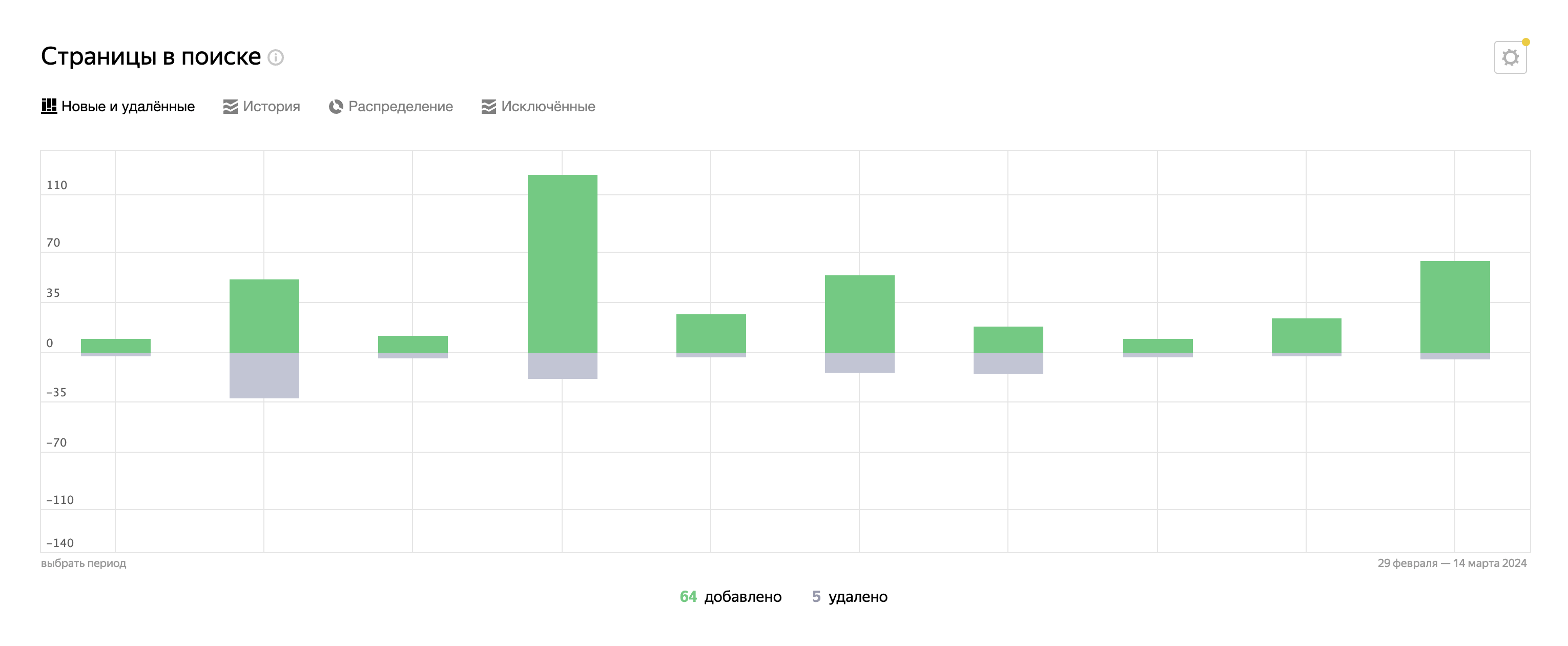

Запрет индексации важных страниц и пагинации

Проверьте не запрещены ли для индексации важные страницы. Ознакомьтесь со списком исключенных страниц в разделах:

Страницы в поискев Яндекс.Вебмастер,Индексирование страницв Google Search Console.

Запрет индексации файлов

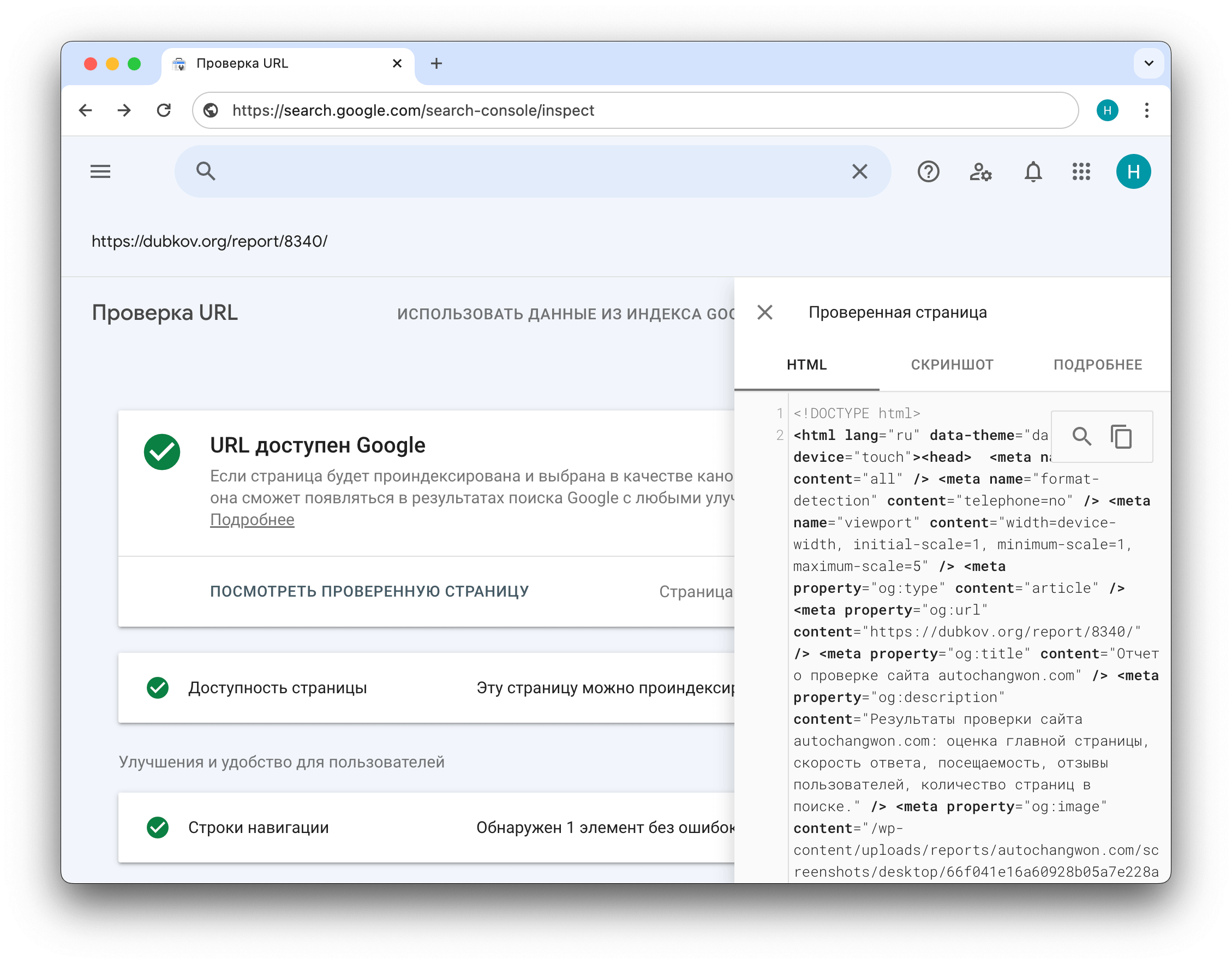

Ресурсы из которых состоит оформление страницы, к ним относятся изображения, стили и скрипты могут быть запрещены для индексирования, что негативно влияет на представление страниц.

Для проверки состояния страниц, кроме просмотра сохраненной копии, можно использовать инструмент Проверка URL от Google. Убедитесь, что для робота доступны файлы из исходного кода страницы, а дизайн сайта на вкладке Скриншот отображается корректно.

Нет правил обхода страниц с GET-параметрами

Страницы с параметрами могут быть актуальны для проектов, где применяется установка метаданных в зависимости от значения параметра.

Например, результаты сортировки товаров по свойствам в каталоге интернет-магазина. Такие страницы признаются уникальными и запрещать их индексирование не требуется.

Если применение параметров не влияет на представление и содержание страницы, то такие URL следует исключить из поиска.

Разрешена индексация малополезного контента

Служебные страницы и системные каталоги сайта, которые не имеют ценности для пользователя должны быть закрыты для индексации.

Карты сайта Sitemap.xml

Sitemap.xml — один или несколько файлов в формате XML, который содержит ссылки на ключевые страницы и разделы сайта. Его наличие требуется для правильной оценки структуры сайта с целью быстрого сканирования URL поисковыми роботами.

Карты упрощают обход сайтов со сложной структурой и высоким уровнем вложенности. Их наличие особенно актуально для ресурсов, где активно применяются технологии: AJAX, JS-фреймворки и Flash.

В процессе проверки Sitemap.xml, убедитесь в том, что:

- Карта сайта оптимально сформирована и доступна для сканирования (веб-сервер отвечает кодом 200 ОК)

- Указана ссылка на карту сайта в директиве Sitemap в файле Robots.txt

Ссылочный профиль

Анализ ссылочной массы позволяет найти токсичные ссылки, которые могут быть причиной пессимизации сайта в поиске. После их устранения, ресурс может благополучно вернуться на прежние позиции в поисковой выдаче.

Входящие ссылки

Для оценки качества ссылочного профиля, помимо Semrush, полезно проверить ссылки вручную. Выгрузите обратные ссылки с помощью консоли для веб-мастеров и проверьте их на заспамленность. Составьте список ссылок с высоким уровнем спама, и воспользуйтесь инструментом от Google для их отклонения.

Исходящие ссылки

Ссылки на другие сайты не должны быть битыми и содержать перенаправлений. Под адресами с редиректами могут скрываться дроп-домены и ресурсы представляющие угрозу для безопасности пользователей.